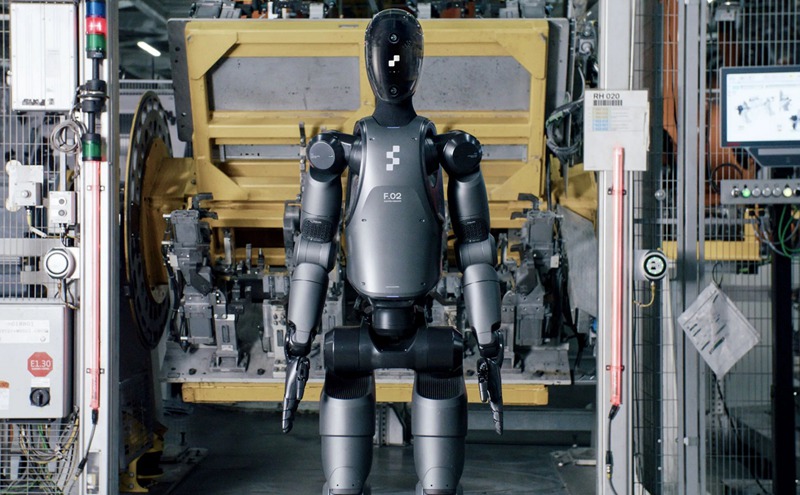

Figure AI最近发布了名为Helix的通用视觉-语言-行动(VLA)模型,这是一个针对人形机器人的先进控制模型。

以下是关于Helix模型的详细介绍:

模型特点:

1、全身控制:Helix是首个能够对整个人形上半身(包括手腕、躯干、头部和单个手指)进行高速率连续控制的VLA模型。

2、多机器人协作:这个模型能够在两台机器人上同时运行,使它们能够协作解决共享的长程操作任务,即使操作的是它们从未见过的物品。

3、强大的泛化能力:Helix可以仅通过自然语言指令,拿起数千种形状、大小、颜色和材料属性各异的全新家用物品,即使这些物品在训练过程中未曾出现过。

4、单一神经网络:与之前的方法不同,Helix使用一组神经网络权重来学习所有行为,如拾取和放置物品、使用抽屉和冰箱以及跨机器人交互,无需针对具体任务进行微调。

技术构成:

Helix由两个部分组成:

1、系统1是一个拥有80M参数的视觉运动策略模型,能够实现毫秒级的实时响应.

2、系统2则是一个基于7B参数的开源VLM(视觉语言模型),负责场景理解与语义解析。

应用潜力:

1、Helix使配备该模型的Figure机器人能够根据自然语言提示,拾取几乎任何小型家用物品。

2、该模型在完全板载嵌入式低功耗GPU上运行,可以立即投入商业部署。

总的来说,Helix模型代表了人形机器人控制领域的一个重要突破,它将感知、语言理解和学习控制能力融为一体,极大地提高了机器人在复杂环境中的操作能力和适应性。